Un estudio de Stanford desmonta uno de los grandes mitos del futuro del trabajo: la inteligencia artificial no está sustituyendo las tareas que las personas quieren automatizar, sino aquellas que prefieren seguir haciendo.

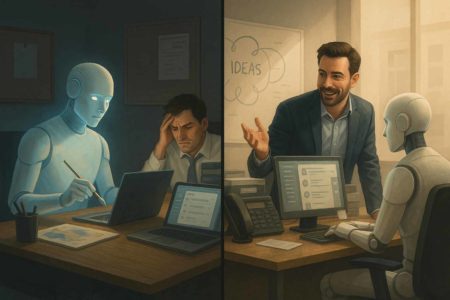

Durante años nos han repetido que la inteligencia artificial (IA) vendrá a reemplazarnos. Primero en los empleos rutinarios y manuales, después en los creativos y, más tarde, incluso en aquellos estratégicos o intelectuales. Se han escrito cientos de artículos hablando del “gran reemplazo” laboral. Y, mientras tanto, hemos visto cómo se canalizaban miles de millones hacia el desarrollo de herramientas cada vez más sofisticadas, muchas de ellas orientadas a simular capacidades humanas.

Pero ¿y si estuviéramos apuntando mal? ¿Y si todo ese esfuerzo estuviera enfocado en sustituir precisamente las tareas que más nos gusta hacer? ¿Y si estuviéramos ignorando otras, mucho más mundanas, donde sí necesitamos ayuda?

Un reciente estudio de la Universidad de Stanford, dirigido por Diyi Yang y Erik Brynjolfsson, nos lanza esa alerta. Su mensaje es claro: estamos construyendo IA para los trabajos equivocados.

El enfoque de Stanford: mirar más allá de lo técnicamente posible

Titulado “Future of Work with AI Agents”, el estudio propone una idea tan obvia como revolucionaria: no basta con saber qué puede hacer la IA; hay que preguntarse también qué queremos que haga. ¿Dónde tiene sentido que intervenga? ¿Dónde puede realmente mejorar nuestra experiencia laboral?

Para explorarlo, el equipo encuestó a 1.500 trabajadores de diferentes sectores en EE. UU. y a más de 750 expertos en IA, cruzando sus respuestas con las capacidades actuales de los agentes inteligentes. El resultado fue WORKBank, una base de datos que clasifica más de 100 ocupaciones según dos criterios:

- Su automatizabilidad técnica con los sistemas actuales.

- El grado de deseo por parte de las personas de delegar esas tareas a una IA.

La gran virtud del estudio es que no se queda en los límites tecnológicos, sino que pone al ser humano en el centro. Ya no se trata solo de lo que puede hacerse, sino de lo que debería hacerse.

Cuatro zonas para comprender mejor la intervención de la IA

Los investigadores clasificaron las ocupaciones en cuatro cuadrantes, según la facilidad con la que pueden ser automatizadas y la voluntad de los usuarios de cederlas:

🟢 Green Light Zone

Son aquellas tareas que sí pueden ser automatizadas y que, además, la gente desea delegar. Ejemplo: introducción de datos, papeleo, seguimiento de inventarios. Son las tareas ideales para agentes de IA.

🔴 Red Light Zone

Tareas que pueden automatizarse técnicamente, pero que la gente no quiere que sean automatizadas. Aquí se sitúan muchas actividades relacionadas con la educación, la atención sanitaria o la creación artística. Automatizarlas genera resistencia emocional, ética y práctica.

🟡 R&D Opportunity Zone

Son tareas donde la IA aún no tiene capacidad suficiente, pero donde sí hay una demanda real de apoyo. Por ejemplo: planificación, negociación, coordinación de proyectos. Esta es una zona de oportunidad para diseñar agentes que actúen como copilotos humanos.

⚪ Low Priority Zone

Tareas difíciles de automatizar y con poco interés por parte de los trabajadores para delegarlas. Aquí el desarrollo de IA no aporta demasiado.

Este esquema no solo organiza el panorama de forma clara; también expone una paradoja: estamos invirtiendo en automatizar donde no hace falta y dejando desatendidos los ámbitos donde realmente se desea ayuda.

El gran malentendido: no todo lo que se puede, se debe automatizar

Uno de los hallazgos más interesantes del estudio es que las personas no quieren ser reemplazadas en las tareas más humanas: aquellas que implican creatividad, empatía, juicio moral o interacción social.

Ejemplos:

- La mayoría de docentes no quieren que una IA dé clases por ellos; quieren apoyo, no sustitución.

- Muchos médicos agradecen sistemas que procesen historiales, pero no quieren que un algoritmo comunique un diagnóstico.

- Los programadores aceptan ayuda con funciones repetitivas, pero disfrutan diseñando arquitecturas lógicas complejas.

En cambio, hay un universo de microtareas que la gente estaría encantada de delegar:

- Gestionar calendarios llenos y caóticos.

- Redactar informes burocráticos sin valor añadido.

- Hacer seguimiento de tickets, KPIs o deadlines.

- Clasificar correos o resumir reuniones interminables.

Y sin embargo, ahí es donde menos atención hemos puesto. La IA se ha volcado en tareas “espectaculares”, en lugar de aliviar las cargas invisibles que desgastan nuestro día a día.

La agencia humana: no queremos perder el control

Otra dimensión clave del estudio es la agencia humana. No todo es una cuestión de eficiencia. Las personas valoramos tener el control, ser parte del proceso, sentirnos relevantes. Hay tareas donde queremos decidir, incluso si una máquina podría hacerlo más rápido.

El equilibrio entre delegar y participar es delicado. Y si la IA irrumpe sin sensibilidad, puede generar rechazo, no adopción. Una buena IA no solo debe ser capaz, sino también saber cuándo intervenir, cómo hacerlo y cuándo dar un paso atrás.

Por eso, el futuro de la IA no pasa solo por mejorar sus capacidades, sino por hacerla más empática, más ajustable y más humilde.

¿Por qué estamos priorizando mal? Algunas causas

¿Cómo hemos llegado a esta desconexión? El estudio sugiere varias razones:

- El éxito de los primeros modelos: GPT para escribir, Copilot para programar, Midjourney para ilustrar. Se convirtieron en estandartes que arrastraron a todo el sector.

- Brillo tecnológico frente a utilidad cotidiana: Crear imágenes que parecen arte genera titulares. Automatizar la gestión de reuniones, no.

- Desconexión con el terreno: Muchos equipos de desarrollo no han pasado ni un día observando cómo trabaja una profesora, un contable o una enfermera. No saben qué fatiga genera cada tarea.

- Narrativas simplificadas: Durante años hemos oído hablar de qué trabajos “va a destruir la IA”. Pocas veces se ha preguntado cómo puede simplemente hacerlos más llevaderos.

Reencaminar el desarrollo: IA útil, accesible y humana

Entonces, ¿qué podemos hacer? ¿Cómo corregimos el rumbo?

El estudio propone un cambio de enfoque: de la sustitución a la colaboración. De la espectacularidad a la relevancia práctica. De la eficiencia a la dignidad y el sentido.

Tres ideas clave:

- Escuchar a los trabajadores reales. No solo a los tecnólogos, inversores o gurús. Preguntar a quienes viven el trabajo diario.

- Construir IA con sensibilidad al contexto. Capaz de adaptarse a cada entorno, tarea y persona.

- Diseñar con control granular. Que el usuario decida qué delega, cómo y cuándo. Con confianza, no con miedo.

Esto implica una nueva cultura del diseño, más ética, más empática y más centrada en el bienestar.

Un futuro más sensato es posible

Imaginemos este escenario:

- Tienes un asistente de IA que escucha tus reuniones, las resume y extrae lo importante.

- Te propone reagendar tus compromisos cuando nota que llevas semanas sin descansar.

- Te ayuda con tu bandeja de entrada, pero te pregunta antes de enviar respuestas sensibles.

- No suplanta tu voz, sino que te da herramientas para afinarla.

Ese futuro no es de ciencia ficción. Está a nuestro alcance si diseñamos con sensatez, sin obsesionarnos con replicar al ser humano, sino con aliviarlo, potenciarlo y acompañarlo.

La paradoja de la IA: ¿potencial desaprovechado?

El estudio de Stanford no solo diagnostica una desconexión. También señala un derroche: hemos construido herramientas poderosísimas, pero no siempre las hemos aplicado donde de verdad marcan la diferencia.

Quizá haya llegado el momento de dejar de preguntarnos “¿qué puede hacer la IA?” y empezar a preguntarnos:

¿Qué sentido tiene que lo haga? ¿Qué papel queremos que tenga en nuestras vidas? ¿Qué tipo de colaboración queremos construir?

Porque el futuro del trabajo no se juega solo en los algoritmos, sino en nuestra capacidad colectiva para decidir cómo convivimos con ellos.

Estudio citado:

Shao, Y., Zope, H., Jiang, Y., Pei, J., Nguyen, D., Brynjolfsson, E., & Yang, D. (2024). Future of Work with AI Agents: Auditing Automation and Augmentation Potential across the U.S. Workforce. Stanford University. https://arxiv.org/abs/2405.18261