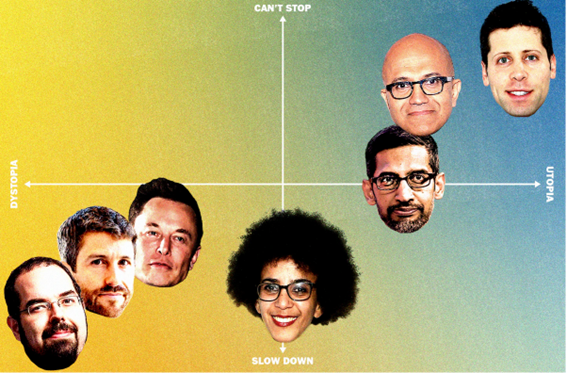

A menudo, desde Europa, tenemos tendencia a ver a Silicon Valley como un bloque ideológicamente compacto. Algo que no se ajusta a la realidad. Ahora, en pleno hype de IA, se confirma esa heterogeneidad revisando la posición ideológica que tiene Silicon Valley en medio del encendido debate alrededor de la IA.

Haciendo un zoom, se observan fuertes divisiones, crecientes y posiciones polarizadas sobre el impacto de una nueva ola de inteligencia artificial: mientras algunos argumentan que es imperativo seguir adelante, otros dicen que la tecnología presenta un riesgo existencial.

Esas tensiones ocuparon un lugar central hace unos meses, cuando Elon Musk, junto con otros ejecutivos tecnológicos y académicos, firmaron la famosa carta Pause Giant AI Experiments: An Open Letter de Future of life institute en la que pedían una pausa de seis meses en el desarrollo de IA «competitiva humana», citando «profundos riesgos para la sociedad y la humanidad».

La periodista Nitasha Tiku escribió el interesante artículo Doomsday to utopia: Meet AI’s rival factions donde define con detalle las diferentes facciones rivales alrededor de la IA.

Unas facciones que en ocasiones se solapan, y en otras en cambio, se contradicen e incluso a veces discrepan con las definiciones básicas.

Pero estas visiones del mundo que alguna vez fueron marginales podrían dar forma a debates fundamentales sobre la IA. Esta guía escrita por Nitasha Tiku ayuda a decodificar las ideologías (e incentivos financieros) detrás de cada una de las facciones:

Seguridad de la IA

El argumento: la frase «seguridad de la IA» se usa para referirse a problemas prácticos, como asegurarse de que los autos sin conductor no choquen. En los últimos años, el término, que a veces se usa indistintamente con «alineación de IA», también se ha adoptado para describir un nuevo campo de investigación para garantizar que los sistemas de IA obedezcan las intenciones de su programador y eviten el tipo de IA que busca poder y que podría dañar a los humanos solo para evitar que se apague.

Muchos tienen vínculos con comunidades como el altruismo efectivo , un movimiento filosófico para maximizar hacer el bien en el mundo. EA, como se le conoce, comenzó priorizando causas como la pobreza global, pero se ha centrado en las preocupaciones sobre el riesgo de la IA avanzada. Los foros en línea, como Lesswrong.com o AI Alignment Forum, albergan debates acalorados sobre estos temas.

Algunos adherentes también se suscriben a una filosofía llamada largoplacismo que busca maximizar el bien durante millones de años. Citan un experimento mental del libro «Superinteligencia» de Nick Bostrom, que imagina que una IA sobrehumana segura podría permitir a la humanidad colonizar las estrellas y crear billones de personas en el futuro. Construir inteligencia artificial segura es crucial para asegurar esas vidas eventuales.

Quién está detrás: en los últimos años, los donantes afiliados a EA como Open Philanthropy, una fundación iniciada por el cofundador de Facebook o Asana, Dustin Moskovitz, y el exfinanciador de cobertura Holden Karnofsky, han ayudado a sembrar una serie de centros, laboratorios de investigación y esfuerzos de desarrollo comunitario centrados en sobre la seguridad de la IA y la alineación de la IA. FTX Future Fund, iniciado por el criptoejecutivo Sam Bankman-Fried, fue otro jugador importante hasta que la empresa quebró después de que Bankman-Fried y otros ejecutivos fueran acusados de fraude.

¿Cuánta influencia tienen?: Algunos trabajan en los mejores laboratorios de IA como OpenAI, DeepMind y Anthropic, donde esta visión del mundo ha llevado a algunas formas útiles de hacer que la IA sea más segura para los usuarios. Una red muy unida de organizaciones produce investigaciones y estudios que se pueden compartir más ampliamente, incluida esta encuesta de 2022 que pidió a los investigadores de aprendizaje automático que estimaran la probabilidad de que la incapacidad humana para controlar la IA pueda acabar con la humanidad. La respuesta mediana fue del 10 por ciento.

AI Impacts, que realizó el estudio, recibió el apoyo de cuatro organizaciones diferentes afiliadas a EA, incluido el Future of Life Institute, que presentó la carta abierta de Musk y recibió su mayor donación de parte de Musk. El cofundador del Center for Humane Technology, Tristan Harris, quien una vez hizo campaña sobre los peligros de las redes sociales y ahora ha centrado su atención en la IA, citó el estudio de manera destacada.

Creyentes de la inteligencia artificial general o AGI

El argumento: No es que a este grupo no le importe la seguridad. Simplemente están extremadamente entusiasmados con la creación de software que alcance la inteligencia artificial general, o AGI, un término para la IA que es tan inteligente y capaz como un ser humano. Algunas son herramientas prometedoras como GPT-4, que OpenAI dice que ha desarrollado habilidades como escribir y responder en idiomas extranjeros sin que se le indique que lo haga, lo que significa que están en el camino hacia AGI. Los expertos explican que GPT-4 desarrolló estas capacidades al ingerir cantidades masivas de datos, y la mayoría dice que estas herramientas no tienen una comprensión humana del significado detrás del texto.

¿Quién está detrás?: Dos laboratorios de IA líderes citaron la creación de AGI en sus declaraciones de misión: OpenAI, fundado en 2015, y DeepMind, un laboratorio de investigación fundado en 2010 y adquirido por Google en 2014. Aun así, el concepto podría haberse mantenido al margen si no fuera por el mismo inversores tecnológicos adinerados interesados en los límites exteriores de la IA. Según el libro de Cade Metz (Genius Makers: los inconformistas que llevaron la IA al mundo), Peter Thiel donó 1,6 millones de dólares a la organización sin fines de lucro de IA de Yudkowsky y Yudkowsky le presentó a Thiel DeepMind. Musk invirtió en DeepMind y le presentó la empresa al cofundador de Google, Larry Page. Musk trajo el concepto de AGI a otros cofundadores de OpenAI, como el director ejecutivo Sam Altman.

¿Cuánta influencia tienen? : El dominio de OpenAI en el mercado ha abierto la ventana de Overton. A los líderes de las empresas más valiosas del mundo, incluido el director ejecutivo de Microsoft, Satya Nadella, y el director ejecutivo de Google, Sundar Pichai, ahora se les pregunta y se habla de AGI en entrevistas . Bill Gates bloguea al respecto. “Debido a que la ventaja de AGI es tan grande, no creemos que sea posible o deseable que la sociedad detenga su desarrollo para siempre”, escribió Altman en febrero.

Los Doomers (fatalistas) de la AI

El argumento: aunque los doomers comparten una serie de creencias, y frecuentan los mismos foros en línea, como personas en el mundo de la seguridad de la IA, esta multitud ha llegado a la conclusión de que si se conecta una IA lo suficientemente potente, acabará con la vida humana.

¿Quién está detrás? Yudkowsky ha sido la principal voz de advertencia sobre este escenario apocalíptico. También es el autor de una popular serie de fan fiction, «Harry Potter y los métodos de la racionalidad», un punto de entrada para muchos jóvenes a estas esferas e ideas en línea en torno a la IA.

Su organización sin fines de lucro, MIRI, recibió un aumento de $ 1.6 millones en donaciones en sus primeros años del inversionista tecnológico Thiel, quien desde entonces se ha distanciado de las opiniones del grupo. Open Philanthropy, alineada con EA, donó alrededor de $ 14,8 millones en cinco subvenciones de 2016 a 2020. Más recientemente, MIRI recibió fondos de los nuevos ricos de crypto, incluido el cofundador de ethereum, Vitalik Buterin.

¿Cuánta influencia tienen?: Si bien algunas personas dentro de este mundo acreditan las teorías de Yudkowsky como proféticas, sus escritos también han sido criticados por no ser aplicables al aprendizaje automático moderno. Aún así, sus puntos de vista sobre la IA han influido en voces de más alto perfil sobre estos temas, como el destacado científico informático Stuart Russell, quien firmó la carta abierta.

En los últimos meses, Altman y otros han elevado el perfil de Yudkowsky. Altman tuiteó recientemente que «es posible que en algún momento [Yudkowsky] merezca el premio nobel de la paz» por acelerar el AGI, y luego también tuiteó una foto de los dos en una fiesta organizada por OpenAI.

Éticos de la IA

El argumento: durante años, los especialistas en ética han advertido sobre los problemas con los modelos de IA más grandes, incluidos los resultados que están sesgados contra la raza y el género, una explosión de medios sintéticos que pueden dañar el ecosistema de la información y el impacto de la IA que suena engañosamente humano. Muchos argumentan que la narrativa del apocalipsis exagera las capacidades de la IA, lo que ayuda a las empresas a comercializar la tecnología como parte de una fantasía de ciencia ficción.

Algunos en este campo argumentan que la tecnología no es inevitable y podría crearse sin dañar a las comunidades vulnerables . Las críticas que se fijan en las capacidades tecnológicas pueden ignorar las decisiones tomadas por las personas, lo que permite a las empresas evitar la responsabilidad por malos consejos médicos o violaciones de la privacidad de sus modelos.

¿Quién está detrás?

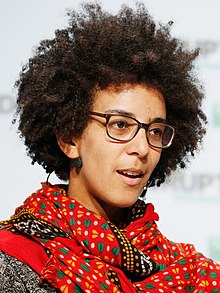

Los coautores de un artículo de investigación con visión de futuro que advierte sobre los daños de los grandes modelos de lenguaje, incluido Timnit Gebru, ex codirector del equipo de IA ética de Google y fundador del Instituto de investigación de IA distribuida, a menudo se citan como voces destacadas. Las investigaciones cruciales que demuestran las fallas de este tipo de IA, así como las formas de mitigar los problemas, «a menudo son realizadas por académicos de color, muchos de ellos mujeres negras», y académicos jóvenes con fondos insuficientes, escribieron los investigadores Abeba Birhane y Deborah Raji en un artículo de opinión para Wired en diciembre.

¿Cuánta influencia tienen? : En medio del auge de la IA, empresas tecnológicas como Microsoft, Twitch y Twitter han despedido a sus equipos de ética de la IA. Pero los políticos y el público han estado escuchando.

El exasesor de políticas de la Casa Blanca, Suresh Venkatasubramanian, quien ayudó a desarrollar el plan para una Declaración de Derechos de la IA, le dijo a VentureBeat que las afirmaciones exageradas recientes sobre las capacidades de ChatGPT eran parte de una «campaña organizada de alarmismo» en torno a la IA generativa que restó valor al trabajo detenido en la IA real. asuntos. Gebru ha hablado ante el Parlamento Europeo sobre la necesidad de un movimiento lento de IA, disminuyendo el ritmo de la industria para que la seguridad de la sociedad sea lo primero.

Foto de Pixabay